AI Act: Новые правила для развития искусственного интеллекта в ЕС

- 1 февраля, 2024

- AI, Data Privacy, Toп статьи

В начале 2024 года на территории европейского союза ЕС вступил в силу AI Act — первый в мире регламент в сфере искусственного интеллекта, который задает новые правила для разработки и использования систем ИИ. Этот закон изменил подход к контролю рисков, обеспечению безопасности и защите прав пользователей в цифровую эпоху. В статье разбираемся, кто должен соблюдать требования нового регламента, как классифицируются ИИ-системы по уровню риска, какой надзорный орган занимается регулированием ИИ, и какие риски несет несоответствие.

Содержание

На кого распространяется EU AI Act?

Действие Регламента ЕС об искусственном интеллекте (EU AI Act) распространяется на все организации, которые разрабатывают или внедряют ИИ и чья деятельность затрагивает людей в Европейском Союзе (ЕС). Регламент устанавливает единые правила для всех, кто разрабатывает, внедряет или использует ИИ-системы в пределах ЕС или взаимодействует с его гражданами.

Сфера применения EU AI Act выходит за географические границы ЕС. Регламент применяется к любой ИИ-системе, которая используется внутри ЕС или использование которой влияет на физических лиц в ЕС, независимо от того, где система была разработана или использована. Такой широкий охват позволяет избежать лазеек для тех, кто хочет избежать соответствия. Системы, которые влияют на граждан ЕС подлежат регулированию, даже если они работают из-за пределов союза.

Требования Акта должны соблюдать все стороны, которые участвуют в жизненном цикле ИИ-систем. При этом объем обязательств зависит от их роли и от уровня риска самой ИИ-системы.

EU AI Act устанавливает разные обязательства для следующих ключевых субъектов:

📎 Провайдеры (Поставщики): Это физическое или юридическое лицо, государственный орган, агентство или другой орган, который разрабатывает ИИ-систему или модель ИИ и выводит ее на рынок ЕС под своим именем или товарным знаком. Провайдеры несут основную ответственность за соответствие.

📎 Развертывающие (Deployers/Пользователи): Это лицо или компания, которая использует ИИ-систему на практике (например, компания, которая использует ИИ, разработанный другой компанией, провайдером, в рекрутинге, или банк, применяющий его для оценки кредитов).

📎 Поставщики моделей ИИ общего назначения (GPAI Models): Отдельные обязательства предусмотрены для провайдеров, которые разрабатывают базовые модели ИИ общего назначения (к ним относят Chat GPT, Perplexity другие схожие модели).

📎 Импортеры, дистрибьюторы и уполномоченные представители также несут определенные обязательства.

Риск-ориентированный подход

Риск-ориентированный подход (Risk-Based Approach, RBA) — основной принцип регулирования Акта об искусственном интеллекте.

Такой подход гарантирует, что жесткость правил для ИИ-систем пропорциональна потенциальному вреду, который они могут причинить людям и обществу. Чем выше потенциальный риск, тем более строгие нормы регулирования применяются.

При этом «риск» определяется как «комбинация вероятности наступления вреда и тяжести этого вреда».

Цель Регламента, основанного на таком подходе, состоит в том, чтобы минимизировать риски, обеспечить безопасность, прозрачность и подотчетность ИИ, а также защитить здоровье, безопасность и фундаментальные права человека.

EU AI Act классифицирует ИИ-системы на основе их потенциального риска для частных лиц и общества и накладывая соответствующие правила на каждую категорию.

Категории риска в EU AI Act

Регламент выделяет четыре основные категории риска:

1) Неприемлемый риск (Запрещенные системы ИИ) (Статья 5)

2) Высокий риск (High-Risk AI Systems) (Статья 6)

3) Ограниченный/Умеренный риск (Limited-Risk AI Systems) (Статья 50)

4) Минимальный риск (Minimal-Risk AI Systems) (Статья 50)

Неприемлемый риск (Запрещенные системы ИИ)

Это системы, которые считаются настолько опасными для прав, здоровья, безопасности или ценностей ЕС, что их вывод на рынок или эксплуатация полностью запрещены. Ввод в эксплуатацию таких систем влечет за собой самые суровые правовые последствия.

К запрещенным относятся:

📎 Системы, которые используют подсознательные или манипулятивные техники для воздействия на поведение человека, если это воздействие может нанести вред.

📎 Системы, которые используют особенности состояния человека (возраст, состояние здоровья, социальное положение) для воздействия на его поведение с целью нанесения вреда.

📎 Системы, которые занимаются классификацией физических лиц на основании биометрических или чувствительных данных (которые трактуются в соответствии с GDPR).

📎 Системы, которые создают социальный рейтинг (социальный скоринг) путем анализа поведения физических лиц.

📎 Системы дистанционного распознавания лиц в режиме «онлайн» (в реальном времени) для правоохранительных целей, за исключением строгих условий и с одобрения суда.

📎 Неограниченный сбор и распознавание фотографий и видео из Интернета или с камер наблюдения без конкретно названной цели.

Высокий риск (High-Risk AI Systems)

Это системы, которые могут оказать значительное воздействие на безопасность или фундаментальные права человека. Такие системы допускаются на рынок, но подлежат самому строгому регулированию (Глава 3 EU AI Act).

Примеры применения ИИ-систем, которые с большой вероятностью будут относиться к высокому риску:

📎 Медицинские устройства и здравоохранение. Например, системы для анализа медицинских изображений и обнаружения опухолей.

📎 Управление работниками и найм (HR). Например, автоматический скрининг резюме и оценка кандидатов.

📎 Критическая инфраструктура: энергетика, транспорт, водоснабжение.

📎 Образование и профессиональная подготовка, например, оценка знаний.

📎 Основные частные и государственные услуги: оценка кредитоспособности, кредитный скоринг, доступ к социальному обеспечению.

📎 Правоохранительные органы, например, оценка риска преступника или анализ доказательств.

📎 Миграция, убежище и пограничный контроль.

📎 Правосудия, например, помощь судьям в толковании закона.

📎 ИИ-системы, которые используются в игрушках.

Такие системы допускаются на рынок, однако к ним применяется самое строгое регулирование: обязательная регистрация в специальном реестре с общим доступом, обязательное проведение оценки воздействия на права и свободы пользователей, создание специальных систем управления и контроля над ИИ, а также ряд технических требований, которые должны обеспечить надежность системы и кибербезопасность.

Статья: Методы обеспечения конфиденциальности в алгоритмах машинного обучения

Рассматриваем различные технические методы обеспечения безопасности данных в ИИ-системах.

Ограниченный/Умеренный риск (Limited-Risk AI Systems)

Такие системы не могут причинить значительного вреда людям и обществу, и к ним применяются базовые требования к прозрачности (transparency). Цель состоит в том, чтобы пользователи могли принимать осознанные решения и были информированы о взаимодействии с ИИ.

Примеры ограниченного риска:

📎 Генеративные модели ИИ (например, ChatGPT и подобные модели), которые должны соблюдать требования прозрачности и законодательство ЕС об авторском праве.

📎 Чат-боты или другие системы, которые взаимодействуют с людьми, должны четко идентифицировать себя как машины.

📎 Дипфейки (AI-генерированный или модифицированный контент) должны быть явно помечены как таковые.

📎 Поставщики обязаны публиковать информацию об объектах, защищенных авторским правом, использованных для обучения.

Минимальный риск (Minimal-Risk AI Systems)

Эти приложения уже широко используются и составляют большинство ИИ-систем, с которыми мы взаимодействуем. Они не представляют существенного риска для прав или безопасности. Большинство систем в этой категории не подлежат обязательным регулирующим нормам в соответствии с AI Act.

Примеры минимального риска:

📎 Спам-фильтры.

📎 ИИ в видеоиграх.

📎 Системы управления запасами.

Компании могут добровольно принять дополнительные кодексы поведения для этих систем.

⚡️ Хотите применять требования EU AI Act на практике? Присоединяйтесь к нашему курсу по регулированию ИИ и научитесь правильно классифицировать системы по уровням риска и разрабатывать соответствующие комплаенс-стратегии.

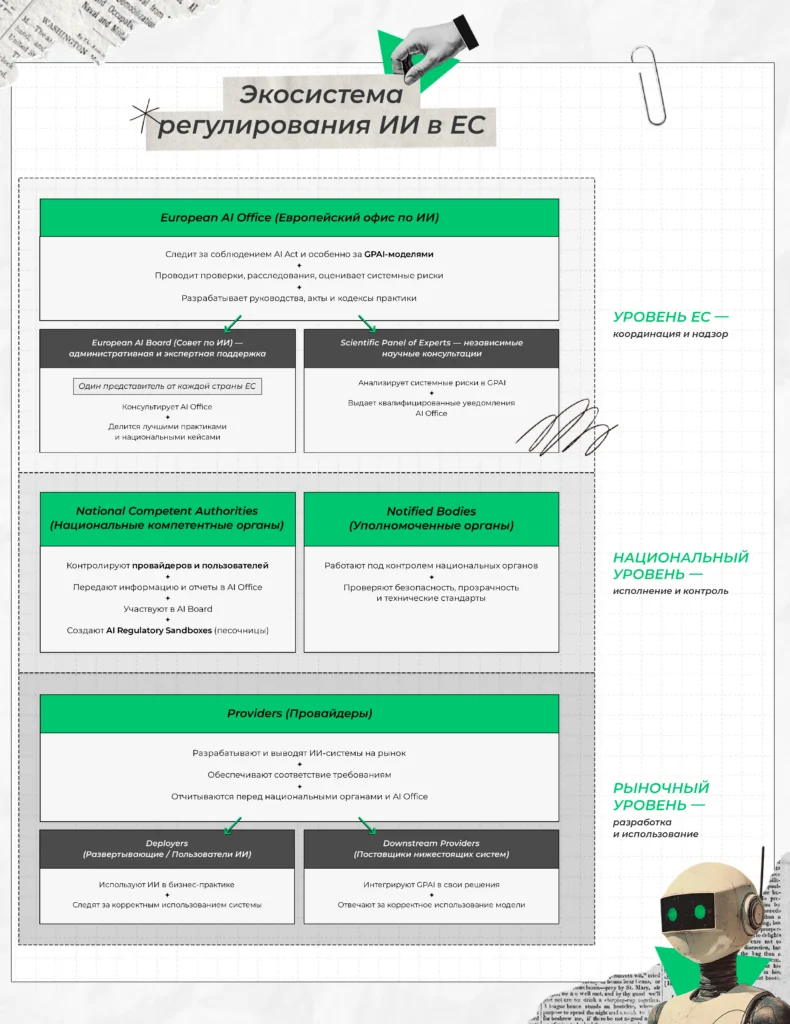

Надзорный орган — European AI Office

Европейский офис по искусственному интеллекту (European AI Office, AI Office) является главным надзорным органом для Регламента ЕС об искусственном интеллекте.

Схема регулирования ИИ в Евросоюзе — в pdf

Перед тем, как углубиться в регулирование ИИ в ЕС, предлагаем посмотреть на эту схему. В ней мы собрали основные роли и уровни взаимодействия, чтобы вам было проще ориентироваться.

Этот орган был создан Европейской комиссией, находится в ее структуре, а именно в Генеральном директорате по сетям связи, контенту и технологиям (DG CNECT).

Основная цель AI Office — следить за единообразным применением AI Act во всех государствах-членах ЕС.

Чем занимается AI Office?

1) Надзор и правоприменение

AI Office несет ответственность за мониторинг, надзор и принудительное исполнение требований AI Act. Среди его зада в этом направлении:

📎 Отслеживать, соблюдается ли Регламент.

📎 Вести расследования в случае нарушения.

📎 Накладывать санкции за нарушение законодательства.

📎 Создавать юридические акты для применения и разъяснения регламента.

2) Регулирование ИИ общего назначения (GPAI) и системных рисков

AI Office играет центральную роль в контроле наиболее мощных моделей ИИ, которые несут системный риск:

📎 Анализ системных рисков: Офис анализирует возникающие непредвиденные системные риски, связанные с разработкой и развертыванием GPAI.

📎 Оценка возможностей моделей: Разрабатывает инструменты, методологии и бенчмарки для оценки возможностей моделей GPAI, особенно тех, которые обладают наибольшим потенциальным воздействием на права людей.

📎 Проведение оценки моделей: AI Office может проводить собственные оценки моделей (model evaluations), если предоставленная документация и информация недостаточны для оценки соответствия через API или доступ к исходному коду.

📎 Требование документации: Требует от провайдеров GPAI моделей предоставить техническую документацию, отчеты о тестировании и другую информацию, необходимую для оценки соответствия.

📎 Меры по снижению рисков: В случае выявления серьезной и обоснованной системной угрозы, AI Office может потребовать от провайдера принять меры по смягчению последствий. Если риски сохраняются, Офис может ограничить, отозвать или вывести модель GPAI с рынка.

📎 Отчетность о серьезных инцидентах: Поставщики GPAI с системным риском обязаны отслеживать и сообщать в AI Office о серьезных инцидентах и принятых корректирующих мерах.

3. Разработка рекомендаций и стандартизация AI Office разрабатывает вспомогательные документы, необходимые для практического применения Регламента:

- Кодексы практики: Офис содействует разработке добровольных кодексов практики (Codes of Practice) для GPAI, чтобы помочь индустрии соблюдать юридические обязательства по безопасности, прозрачности и авторскому праву. Присоединение к таким кодексам позволяет провайдерам демонстрировать соответствие своим обязательствам. А это снижает административную нагрузку и дает больше правовой определенности.

- Руководства: Разрабатывает рекомендации и инструкции, соответствующие Регламенту. Например, 22 апреля 2025 года AI Office опубликовал предварительные руководящие принципы, разъясняющие сферу применения обязательств для провайдеров GPAI.

- Шаблоны: Разрабатывает шаблон для провайдеров GPAI для публикации достаточно подробного резюме контента, который использовался для обучения модели, чтобы облегчить сторонам с законными интересами осуществление их прав.

4. Координация и поддержка AI Office выполняет координирующие и поддерживающие функции:

📎 AI Board (Совет по ИИ): Офис выступает в качестве Секретариата для AI Board — консультационного органа, который состоит из представителей государств-членов ЕС. Он координирует внедрение Акта на национальном уровне.

📎 Научная группа независимых экспертов: Офис оказывает административную поддержку Научной группе независимых экспертов, которая его консультирует. Эта группа может выдавать квалифицированные оповещения о системных рисках.

📎 Поддержка МСП: AI Office предоставляет информацию и ресурсы для малых и средних предприятий (МСП), разрабатывает упрощенные формы технической документации и организует информационные кампании.

📎 Регулятивные песочницы (Regulatory Sandboxes): Офис оказывает техническую поддержку и консультации для создания и функционирования регулятивных песочниц ИИ, которые позволяют компаниям (особенно МСП) тестировать ИИ-системы в контролируемой среде.

📎 Международное сотрудничество: Координирует глобальные усилия в области ИИ и способствует международному сотрудничеству в области управления ИИ.

Конфиденциальность информации: Информация, предоставляемая в AI Office, должна обрабатываться в соответствии с требованиями конфиденциальности, установленными в Статье 78 AI Act. Офис должен сохранять коммерческую тайну и права интеллектуальной собственности.

Через два года после вступления Акта в силу (к июню 2026 года) Комиссия оценит, были ли AI Office предоставлены достаточные полномочия и ресурсы для выполнения его задач.

Штрафы за нарушение AI Act

Штрафы (санкции) за нарушение AI Act даже больше, чем за нарушение требований GDPR, но рассчитываются также — пропорционально риску нарушения.

Статья: 12 самых известных штрафов за нарушение GDPR

Расширяем контекст о нарушениях GDPR и рассказываем, как компании получают за это штрафы до 50 миллионов евро.

Как мы уже упомянули выше, за наложение штрафов отвечает европейский AI Office.

В общем случае, если компания не соблюдает требования, ей грозит штраф, который снова как в GDPR составляет фиксированную сумму или установленный процент от общего мирового годового оборота организации за предшествующий финансовый год: до 35 миллионов евро или 7% от общемирового годового оборота в зависимости от того, что выше.

Регламент предусматривает три основных уровня штрафов, а также специальные штрафы для поставщиков моделей ИИ общего назначения (GPAI).

Запрещенные практики ИИ (Неприемлемый риск)

Это самая высокая категория нарушений, связанная с вводом в эксплуатацию или размещением на рынке запрещенных систем ИИ.

Вид нарушения | Максимальный штраф (фиксированная сумма) | Максимальный процент от мирового оборота |

|---|---|---|

Нарушение запретов в отношении систем ИИ с неприемлемым риском. | €35 миллионов | 7% от общемирового годового оборота |

Нарушение других обязательств AI Act

Эта категория охватывает большинство других обязательств, в том числе и требования к высокорисковым системам ИИ и обязанности всех участников цикла разработки ИИ.

Вид нарушения | Максимальный штраф (фиксированная сумма) | Максимальный процент от мирового оборота |

|---|---|---|

Несоблюдение обязательств провайдеров или deployer. | €15 миллионов | 3% от общемирового годового оборота |

Пример:

Невыполнение требований по внедрению Системы управления рисками (RMS) или Системы управления качеством (QMS) для высокорисковых систем, или несоблюдение обязательств по человеческому надзору (Статья 14).

Предоставление ложной информации

Штрафы налагаются за предоставление неточной или вводящей в заблуждение информации надзорным органам или уполномоченным органам.

Вид нарушения | Максимальный штраф (фиксированная сумма) | Максимальный процент от мирового оборота |

|---|---|---|

Предоставление ошибочной, неполной или вводящей в заблуждение информации надзорному органу. | €7,5 миллионов | 1% от общемирового годового оборота |

Специальные штрафы для моделей ИИ общего назначения (GPAI)

Для поставщиков моделей ИИ общего назначения (таких как ChatGPT-подобные модели) также предусмотрены значительные штрафы за несоблюдение их специфических обязательств.

Вид нарушения | Максимальный штраф (фиксированная сумма) | Максимальный процент от мирового оборота |

|---|---|---|

Нарушения, связанные с моделями GPAI (например, несоблюдение требований к документации, прозрачности или непредоставление доступа для оценки). | €15 миллионов | 3% от общемирового годового оборота |

Смягчающие обстоятельства и сроки вступления в силу

1) Смягчение штрафов для МСП: Для малых и средних предприятий (МСП) и стартапов, хотя они и должны соблюдать Регламент, предусмотрены более мягкие максимальные штрафы. В отличие от крупных компаний, для МСП верхний предел штрафа устанавливается по принципу «наименьшее из двух» (фиксированная сумма или процент от мирового оборота).

2) Роль Code of Practice: Поставщики моделей GPAI могут добровольно присоединиться к Кодексу практики (Code of Practice). Соблюдение этого Кодекса может быть учтено в качестве смягчающего фактора при определении размера штрафов.

3) Сроки принудительного исполнения: Принудительное исполнение Регламента не началось сразу после его принятия. Бизнесу было предоставлено переходное время. Например, в отношении правил GPAI, хотя они вступили в силу 2 августа 2025 года, полномочия по их принудительному исполнению начнут действовать годом позже, 2 августа 2026 года. В целом, компании могут иметь от 1,5 до 3 лет на адаптацию, прежде чем начнут налагаться штрафы.

4) Влияние на HR-системы: Компания, которая существенно модифицировала и выпустила под своим брендом высокорисковую систему ИИ (например, для найма персонала, что прямо классифицируется как высокорисковое применение), несет ответственность как провайдер. За несоблюдение требований этой роли она может столкнуться со штрафами до 35 млн евро или 7% от глобального оборота.

Когда вступает в силу AI Act?

AI Act был принят в результате поэтапного процесса и вступает в силу также поэтапно. Это позволяет постепенно адаптироваться к новым требованиям.

Вступление в силу и принятие EU AI Act

Политическое соглашение по Регламенту было достигнуто Советом Европейского Союза и Европейским парламентом в декабре 2023 года.

Закон был принят Европейским парламентом 13 марта 2024 года и одобрен Советом в мае 2024 года.

Официальной датой вступления в силу Регламента (началом отсчета для всех сроков) является 1 августа 2024 года.

Этапы применения и внедрения (Phased Approach)

Регулирование ЕС в области ИИ вводится в действие поэтапно, с различными регуляторными требованиями, вступающими в силу через 6, 12, 18, 24 и 36 месяцев с момента первоначального вступления в силу 1 августа 2024 года.

Фаза 1: 6 месяцев (С 2 февраля 2025 года)

Первая фаза реализации наступила 2 февраля 2025 года.

На этом этапе стали обязательными следующие требования:

📎 Запрет неприемлемых рисков: Вступил в силу запрет на системы ИИ, представляющие неприемлемый риск.

📎 AI-грамотность (AI Literacy): Если организация работает на европейском рынке, то она должна обучить сотрудников, которые так или иначе работают с ИИ-системами, их грамотному использованию и разработке (Статья 4).

Статья: Как обучить команду защите персональных данных?

Рассматриваем два подхода к организации обучения по data privacy и AI в компании: самостоятельными силами DPO и с помощью подрядчиков.

Фаза 2: 12 месяцев (С 2 августа 2025 года)

Вторая фаза реализации наступила 2 августа 2025 года.

На этом этапе вступили в силу обязательства для провайдеров моделей ИИ общего назначения (GPAI models).

Обязательства включают:

📎 Прозрачность и документация: Провайдеры должны обеспечить прозрачность модели и создать необходимую техническую документацию (Annexes XI and XII).

📎 Авторское право: Компании обязаны создать и соблюдать политику соответствия модели законодательству ЕС об авторском праве.

📎 Системный риск: Провайдеры моделей GPAI, классифицированных как несущие системный риск, должны выполнять дополнительные обязательства: тестирования, оценки, регистрация инцидентов и обеспечение информационной безопасности.

Фаза 3: 24 месяца (С 2 августа 2026 года)

Эта фаза наступит через 24 месяца после вступления в силу акта, то есть 2 августа 2026 года.

📎 Высокорисковые системы: Начнут применяться правила для большинства высокорисковых систем ИИ (Глава 3), которые не подпадают под действие существующего законодательства ЕС о безопасности продукции (например, игрушек, медицинских устройств, критической инфраструктуры).

📎 Принудительное исполнение GPAI: Вступают в силу полномочия по принудительному исполнению и наложению штрафов за нарушение правил в отношении моделей ИИ общего назначения (GPAI).

Фаза 4: 36 месяцев (С 2 августа 2027 года)

Эта фаза наступит через 36 месяцев, то есть 2 августа 2027 года.

📎Строгие высокорисковые системы: Вступают в силу требования для высокорисковых систем ИИ, используемых в продуктах, которые уже регулируются существующим законодательством ЕС о безопасности продукции.

📎 Переходный период для GPAI: Завершается двухлетний переходный период для существующих моделей GPAI, уже находящихся на рынке.

Призывы к отсрочке применения

В июле 2025 года (непосредственно перед вступлением в силу обязательств GPAI) коалиция европейских компаний, включая крупных игроков: Airbus SE, Mercedes-Benz AG и Mistral AI — обратилась к Европейской комиссии с просьбой отложить реализацию AI Act на два года. Компании выражали опасения, что неясные правила для GPAI могут замедлить инновации и поставить их в невыгодное положение по сравнению с конкурентами в США и Китае. Однако Европейская комиссия отклонила этот запрос и заявила, что продолжит реализацию по графику.

Вместо отсрочки, 10 июля 2025 года Комиссия опубликовала руководящие принципы (Guidelines) и Кодекс практики (Code of Practice), который должен был помочь отрасли в соблюдении обязательств GPAI. Присоединение к Кодексу практики является добровольным, но позволяет провайдерам продемонстрировать соответствие и уменьшить административную нагрузку.

Почему AI Act противоречит GDPR?

Главное противоречие между EU AI Act и GDPR — в том, что первый требует бороться с предвзятостью в ИИ, а второй строго ограничивает использование чувствительных персональных данных.

С одной стороны, AI Act обязывает разработчиков проверять свои алгоритмы на справедливость и допускает обработку некоторых чувствительных данных, если это необходимо для выявления и устранения предвзятости.

С другой — GDPR прямо запрещает обработку таких данных, например, о расе, здоровье или сексуальной ориентации.

В итоге компании оказываются между двух требований: чтобы проверить, не дискриминирует ли ИИ, нужно иметь данные о защищённых характеристиках, но их использование может нарушить GDPR.

Статья: Как EU AI Act влияет на бизнес в Европе (и за ее пределами).

Рассказываем, что делать бизнесу, который использует ИИ, и как избежать противоречия AI Act с GDPR.

Подробнее об этом рассказали в статье.

Подытожим

EU AI Act постепенно становится такой же важной частью европейского регулирования, как и GDPR. Со своими правилами и штрафами он может показаться непонятным и слишком обязывающим, хотя это — просто очередной ответ на изменяющийся ландшафт рисков для пользователей. Чтобы быть уверенным в том, что к моменту полного вступления в силу Акта, вы готовы к его требованиям, советуем заняться комплаенсом уже сейчас.

Помощь и поддержка по вопросам соответствия EU AI Act

В условиях новых европейских правил для ИИ важно не только понимать законодательство, но и оперативно приводить свои системы в соответствие. Мы готовы помочь вам на каждом этапе.

Практический курс, который даст вам и вашей команде четкие знания о Регламенте, его рисках и способах безопасного внедрения AI. Вы научитесь правильно оценивать ИИ-системы и применять соблюдать требования на практике.

Обучим основам искусственного интеллекта и принципам его регулирования в Европе на основе закона EU AI Act. Расскажем, как связаны приватность и системы ИИ и как минимизировать риски для персональных данных при их разработке.

Наши эксперты проведут всесторонний аудит ваших ИИ-систем, выявят риски и несоответствия, а также разработают персональную дорожную карту для приведения бизнеса в соответствие. Это позволит избежать штрафов и защитить репутацию компании.