Штрафы за нарушение GDPR в системах ИИ и как их избежать

- 6 мая, 2025

- Data Privacy, Для бизнеса

По данным Stanford Artificial Intelligence Index Report 2024, генеративный ИИ привлек 33,9 млрд долларов частных инвестиций по всему миру, что на 18,7 % больше, чем в 2023 году. Генеративные модели используются уже не только для рекламы и контента, но и в HR, медицине и принятии управленческих решений.

На этом фоне вопрос приватности звучит особенно остро. Как обеспечить защиту персональных данных в реальности, где алгоритмы могут не просто анализировать, но и принимать решения?

С увеличением использования ИИ возрастает и обеспокоенность по поводу защиты персональных данных пользователей. Европейские регуляторы усиливают контроль за соблюдением GDPR в контексте ИИ.

В этой статье мы проанализируем пять кейсов нарушений требований GDPR, зафиксированных с конца 2024 по начало 2025 года. Каждый из них — это реальный пример, с которым сталкиваются команды разработчиков, CPO и специалисты по защите данных. И каждый — возможность понять, как строить работу на стыке AI & Data Privacy без страха и с пониманием.

Содержание

LinkedIn – штраф в €310 миллионов за скрытое поведенческое профилирование (октябрь 2024)

Что произошло: LinkedIn отслеживал не только активность пользователей социальной сети (лайки, посты, подписки), но и поведенческие сигналы — например, как долго человек задерживался на посте или как быстро прокручивал ленту. Эти сигналы использовались для определения личностных характеристик (например, заинтересованность в смене работы, вероятность профессионального выгорания) и для работы предиктивных алгоритмов доставки рекламы и внутренних систем ранжирования.

Что пошло не так: Ирландский надзорный орган установил, что это поведенческое профилирование проводилось без согласия пользователей и нарушало принципы прозрачности, справедливости и ограничения целей согласно Статье 5 и 6 GDPR.

Результат: Был выписан рекордный штраф в размере 310 миллионов евро. LinkedIn также обязали внедрить механизмы получения согласия в реальном времени, переработать систему сбора поведенческих данных и пересмотреть настройки персонализации рекламы по умолчанию.

Урок: Выводы на основе ИИ — даже из казалось бы «анонимных» поведенческих паттернов — подпадают под действие GDPR, если они связаны с идентифицируемыми лицами.

Meta (Facebook) – штраф в €251 миллион за утечку данных 2018 года (сентябрь 2024)

Что произошло: В 2018 году уязвимость в функции Facebook «View As» позволила мошенникам получить токены доступа к учетным записям пользователей — в результате чего были раскрыты персональные данные 29 млн пользователей (имена, электронные адреса, номера телефонов, местоположения и история поиска). Хотя уязвимость была быстро устранена, юридические последствия утечки длились годами.

Что пошло не так: Ирландский надзорный орган пришел к выводу, что Meta не смогла внедрить «соответствующие технические и организационные меры» для обеспечения уровня безопасности, соответствующего риску (Статья 32 GDPR).

Результат: Meta была оштрафована на €251 миллион — что отражает как масштаб утечки, так и её последствия. Компанию также обязали провести аудит и отчитаться о своих системах контроля доступа и практиках управления токенами.

Урок: GDPR касается не только того, как вы собираете данные — но и того, как вы их защищаете. Проблемы с безопасностью, даже в старых унаследованных системах, могут стоить миллионы.

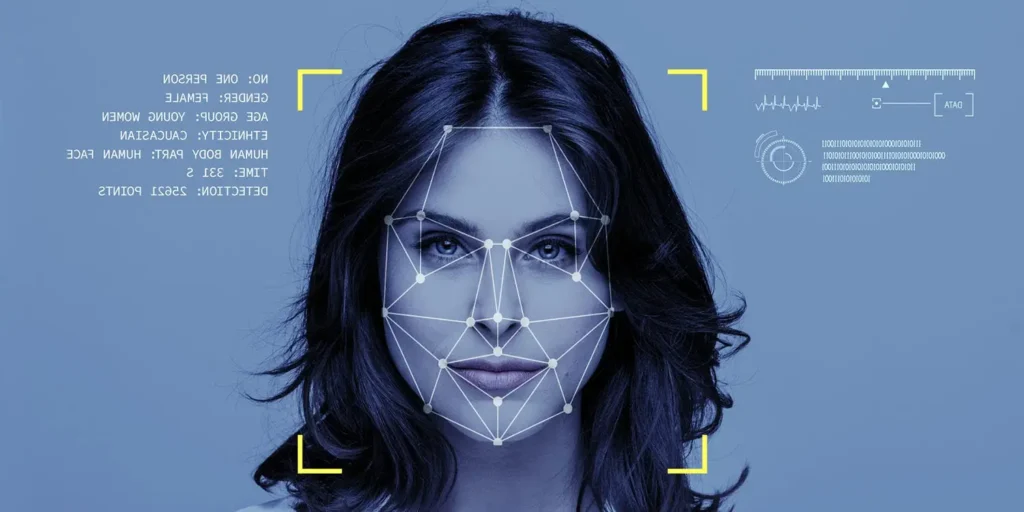

Clearview AI – штраф в €30.5 миллионов за незаконный сбор биометрических данных (сентябрь 2024)

Что произошло: Clearview AI создала огромную базу данных для распознавания лиц, используя более 30 миллиардов изображений, собранных с публичных веб-сайтов — включая LinkedIn, Facebook и даже новостные сайты — без уведомления или согласия субъектов данных. Компания утверждала, что её услуги предназначены только для правоохранительных органов, но регуляторы увидели ситуацию иначе.

Что пошло не так: Биометрические данные классифицируются относятся к специальной категории персональных данных согласно Статье 9 GDPR. Их сбор требует явного согласия или очень узкого правового исключения. У Clearview не было ни того, ни другого. Голландский надзорный орган также отметил отсутствие прав пользователей на доступ и удаление данных.

Результат: Штраф в €30.5 миллионов сопровождался запретом на обработку данных голландских граждан. Ожидается, что другие страны ЕС вынесут аналогичные решения, фактически внося Clearview в черный список для работы в ЕС.

Урок: Сбор публичных данных не освобождает от соблюдения GDPR. Источник не имеет значения — важна идентифицируемость и чувствительность данных.

OpenAI (ChatGPT) – штраф в €15 миллионов за непрозрачность и доступ несовершеннолетних (декабрь 2024)

Что произошло: Итальянский Garante изначально запретил ChatGPT в марте 2023 года, ссылаясь на непрозрачные практики обработки данных и отсутствие проверки возраста пользователей. После переговоров и улучшений со стороны OpenAI сервис возобновил работу, но расследования продолжились.

Что пошло не так: Garante пришел к выводу, что у OpenAI отсутствовало правовое основание для обработки данных европейских пользователей при обучении модели. Компания также не предоставила четкой информации о том, как данные используются, хранятся или удаляются. Дети могли регистрироваться без реальной проверки возраста.

Результат: Штраф в €15 миллионов сопровождался требованием к OpenAI провести шестимесячную кампанию по информированию общественности и внедрить более строгие меры защиты приватности во всех своих продуктах.

Чему это учит: Сложность систем ИИ не оправдывает несоблюдение требований. Политики должны объяснять — четко и кратко — как ИИ использует данные, а пользователи должны иметь реальный контроль.

TikTok – штраф в €345 миллионов за неправильное обращение с данными детей (сентябрь 2024)

Что произошло: TikTok был оштрафован за то, что позволял пользователям младше 13 лет создавать аккаунты, загружать видео и взаимодействовать с платформой без проверки возраста или родительского контроля. Настройки профиля по умолчанию делали контент и личные данные общедоступными.

Что пошло не так: Согласно GDPR, данные несовершеннолетних должны обрабатываться с большей защитой — особенно в отношении согласия и профилирования. TikTok не смог защитить эти права детей, а его темные паттерны отбивали у пользователей желание менять настройки приватности.

Результат: Ирландский надзорный орган оштрафовал TikTok на €345 миллионов и потребовала полной архитектурной переработки, включая настройки приватности по умолчанию для всех несовершеннолетних и более строгие механизмы контроля возраста.

Урок: Защита детей в интернете является одним из главных приоритетов регуляторов. Платформы должны выходить за рамки формального подхода, чтобы продемонстрировать реальное снижение рисков.

Узнать о нарушении требований можно (и нужно) до получения штрафа.

Достаточно вовремя выявить уязвимости в подходах к защите персональных данных — до того, как это сделают пользователи, конкуренты или регуляторы. Особенно когда речь идёт об ИИ-системах, которые быстро эволюционируют, но не всегда развиваются с соблюдением принципов Privacy by Design.

В этом поможет AI Compliance Gap Assessment — аудит, который покажет:

— где система ИИ рискует выйти за рамки требований,

— какие процессы требуют усиления,

— и как это исправить с минимальными затратами и максимальной пользой.

Проверьте, насколько ваш ИИ отвечает стандартам приватности.

Как создавать ИИ-системы с учетом требований GDPR и избежать подобных штрафов?

Недавние случаи правоприменения показывают не только технические недостатки — они раскрывают слепые зоны в этике, ответственности и соблюдении требований. Для разработчиков систем на базе ИИ мы подготовили 8 практических рекомендаций, которые помогут соответствовать регулированию и укреплять доверие пользователей.

ИИ подчиняется GDPR — без исключений

Даже если ваша система ИИ не «похожа» на обработку персональных данных, если она касается идентифицируемых или выводимых пользовательских данных — она подпадает под GDPR.

Действие: Проведите оценку воздействия на защиту данных (DPIA) перед запуском любого проекта ИИ, который обрабатывает персональные данные.

Будьте радикально прозрачны

Пользователи должны знать, какие данные собираются и как они используются, а также как на них влияют автоматизированные решения. Расплывчатых или общих уведомлений о защите данных недостаточно.

Действие: Создайте специальные уведомления о приватности для ИИ с понятными описаниями и визуальными пояснениями.

Сделайте согласие значимым — или не полагайтесь на него

Если вы используете согласие как правовое основание, оно должно быть добровольным, конкретным, информированным и однозначным. Связанные или предварительно отмеченные согласия недействительны.

Действие: Внедрите панели управления согласием в реальном времени, где пользователи могут управлять разрешениями для данных, используемых в функциях ИИ.

Биометрические и поведенческие данные = высокий риск

Сканирование лица, анализ эмоций, отслеживание движений глаз и перемещений курсора мыши — все эти данные относятся к биометрическим или поведенческим показателям и требуют повышенных стандартов защиты по GDPR.

Действие: Избегайте сбора этих категорий, если они не так важны. Если все же необходимы, применяйте шифрование, журналы доступа и разделение обязанностей.

Создавайте системы с учетом возраста

Если ваше приложение или платформа может привлекать несовершеннолетних пользователей, проверка возраста не опциональна — она необходима.

Действие: Внедрите технологии определения или проверки возраста и человеческую модерацию. Разработайте интерфейсы, которые препятствуют чрезмерному раскрытию информации детьми.

Проектируйте с учетом приватности с самого начала

Исправлять ошибки дороже (во всех смыслах), чем не допускать их с самого начала. Встройте принципы приватности в архитектуру продукта: ограничьте хранение данных, сократите их объем и анонимизируйте на ранних этапах.

Действие: Интегрируйте принципы privacy by design в разработку — не только в политики.

Документируйте все

От источников данных для обучения до алгоритмической логики: GDPR требует подотчетности. Если вы не можете объяснить свою модель, регуляторы (и пользователи) не будут ей доверять.

Действие: Ведите внутренние аудиторские следы ИИ — включая версии моделей, сводки входных данных и ключевые проектные решения.

Предвидьте предвзятость и тестируйте ее

ИИ может непреднамеренно усиливать дискриминацию — особенно при найме, кредитовании или в жилищной сфере.

Действие: Проводите аудиты справедливости, моделируйте крайние случаи и обучайте команду выявлять риски предвзятости в данных и результатах.

Заключение

Будущее ИИ будет построено не только на инновациях — но и на ответственности. Регуляторы больше не терпят расплывчатых обещаний и скрытых алгоритмов. Создание надежных систем, ориентированных на приватность — это не просто правильный поступок, это конкурентное преимущество.

Помощь и поддержка по вопросам соответствия EU AI Act

В условиях новых европейских правил для ИИ важно не только понимать законодательство, но и оперативно приводить свои системы в соответствие. Мы готовы помочь вам на каждом этапе.

Практический курс, который даст вам и вашей команде четкие знания о Регламенте, его рисках и способах безопасного использования ИИ. Вы научитесь правильно оценивать ИИ-системы и применять соблюдать требования на практике.

Обучим основам искусственного интеллекта и принципам его регулирования в Европе на основе закона EU AI Act. Расскажем, как связаны приватность и системы ИИ и как минимизировать риски для персональных данных при их разработке.

Наши эксперты проведут всесторонний аудит ваших ИИ-систем, выявят риски и несоответствия, а также разработают персональную дорожную карту для приведения бизнеса в соответствие. Это позволит избежать штрафов и защитить репутацию компании.

Готовы действовать на опережение, а не тушить пожары?

- Запишитесь на консультацию с экспертами Data Privacy Office, чтобы:

- Оценить риски обработки персональных данных в ИИ-системах

- Получить чёткую дорожную карту по соответствию GDPR и AI Act

- Усилить доверие клиентов и регуляторов

- Не ждите штрафа — начинайте строить доверие уже сегодня.